HMoE – 騰訊混元團隊提出的新型神經(jīng)網(wǎng)絡(luò)架構(gòu)

HMoE是什么

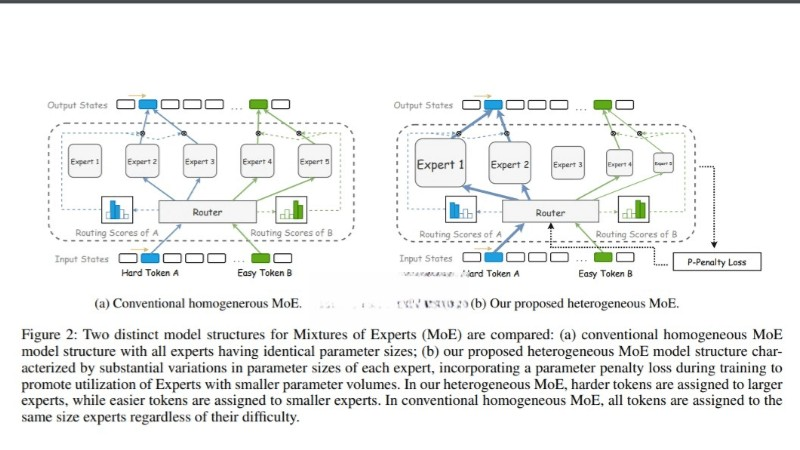

HMoE(混合異構(gòu)專家模型)是騰訊混元團隊提出的新型神經(jīng)網(wǎng)絡(luò)架構(gòu),旨在提升大型語言模型的性能和計算效率。通過引入不同尺寸的專家來處理不同復(fù)雜性的輸入數(shù)據(jù),從而增強模型的專業(yè)化程度。HMoE采用新的訓練目標和策略,如P-Penalty Loss,鼓勵頻繁激活更小的專家,以提高參數(shù)利用率和計算效率。實驗證明,HMoE在多個預(yù)訓練評估基準上性能卓越,為大模型研究提供了新方向。

HMoE的功能特色

- 異構(gòu)專家設(shè)計:HMoE模型中的專家尺寸不一,能根據(jù)輸入數(shù)據(jù)的復(fù)雜性分配不同能力的專家進行處理,提高模型的專業(yè)化和靈活性。

- 計算效率優(yōu)化:通過激活更小的專家來處理簡單任務(wù),HMoE在保持高效計算的同時,能將計算資源集中于更復(fù)雜的任務(wù)。

- 參數(shù)利用效率:HMoE通過P-Penalty Loss等訓練策略,優(yōu)化了參數(shù)的分配和激活,減少了對大型專家的依賴,提升了模型整體的參數(shù)使用效率。

- 動態(tài)路由策略:結(jié)合Top-P和Top-K路由策略,HMoE能根據(jù)每個token的重要性動態(tài)地激活相應(yīng)數(shù)量的專家,實現(xiàn)更加精細化的模型控制。

- 性能提升:在多個預(yù)訓練評估基準上,HMoE展現(xiàn)出超越傳統(tǒng)同質(zhì)MoE模型的性能,證明在處理復(fù)雜語言任務(wù)上的有效性。

HMoE的技術(shù)原理

- 異構(gòu)專家結(jié)構(gòu):HMoE模型由多個不同尺寸的專家組成,每個專家都是一個獨立的神經(jīng)網(wǎng)絡(luò),能處理輸入數(shù)據(jù)的不同方面。允許模型根據(jù)任務(wù)的復(fù)雜性動態(tài)分配計算資源。

- 路由機制:HMoE使用路由策略(如Top-K和Top-P路由)來決定哪些專家將被激活以處理特定的輸入。Top-K路由固定激活K個專家,而Top-P路由根據(jù)概率閾值動態(tài)確定激活專家的數(shù)量。

- 參數(shù)化損失函數(shù):為了解決專家激活不平衡的問題,HMoE引入了參數(shù)化損失函數(shù)(P-Penalty Loss),該損失函數(shù)根據(jù)專家的尺寸調(diào)整其在總損失中的權(quán)重,鼓勵模型更多地激活小型專家。

- 訓練目標優(yōu)化:HMoE通過優(yōu)化訓練目標,不僅考慮模型性能,還考慮參數(shù)的高效利用。通過結(jié)合語言模型損失、P-Penalty Loss和路由器熵損失(Lentropy)來實現(xiàn)。

HMoE的項目地址

- arXiv技術(shù)論文:https://arxiv.org/pdf/2408.10681

HMoE的應(yīng)用場景

- 自然語言處理(NLP):HMoE可以應(yīng)用于機器翻譯、文本摘要、情感分析、文本分類、問答系統(tǒng)等NLP任務(wù),基于異構(gòu)專家處理不同語言特性的能力。

- 內(nèi)容推薦系統(tǒng):在推薦系統(tǒng)中,HMoE可以分析用戶行為和偏好,提供個性化的內(nèi)容推薦。

- 語音識別:HMoE可以應(yīng)用于語音識別技術(shù),處理不同說話者的特征和語音中的復(fù)雜信息。

- 圖像和視頻分析:雖然HMoE主要設(shè)計用于處理語言模型,但其異構(gòu)專家的概念也可以擴展到圖像和視頻分析領(lǐng)域,處理視覺數(shù)據(jù)的不同方面。

- 多模態(tài)學習:在處理結(jié)合文本、圖像和聲音等多種數(shù)據(jù)類型的任務(wù)時,HMoE可以有效地分配專家處理不同模態(tài)的數(shù)據(jù)。

? 版權(quán)聲明

本站文章版權(quán)歸奇想AI導(dǎo)航網(wǎng)所有,未經(jīng)允許禁止任何形式的轉(zhuǎn)載。